+ 후기

수강기간: 20220322 40분

구조 설명 부분이 기똥차다. 컨테이너 선박에 비유하면서 이야기해주는데

이정도 정성의 강의면 들을 가치가 충분하다고 생각한다.

introduction은 어떻게 진행될건지 설명만 하고 있어서, 가볍게 들었다ㅎ

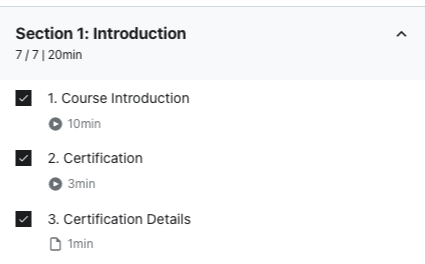

Introduction

7 lectures • 20min

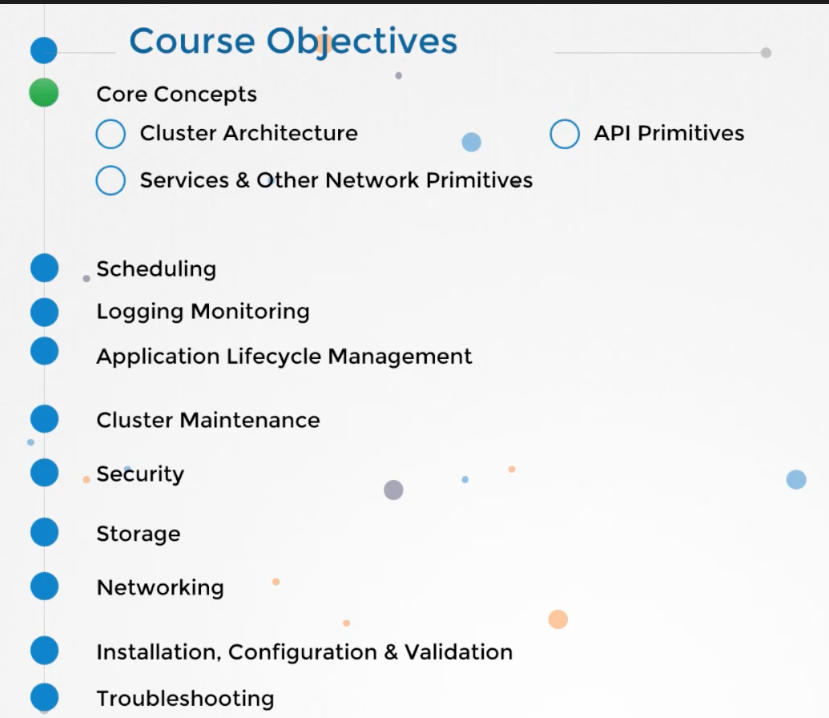

| 1. core concepts

- cluster architecture: 구성

- api primitives: pod, replicaset, ns 같은 것 복습

- services & other network primitives: 나머지

3. logging monitoring : monitor cluster 4. application lifecycle management : rolling updates and rollbacks in deploy + configure applications + scale application, self-healing 5. cluster maintenance : take down nodes + perform and upgrade cluster + backup and restore 6. security : tls certificates 7. storage : pv, pvc 8. Networking : configuration on cluster nodes + ingress, routing, core dns, dns, network ns, CNI, etc 9. Installation, Configuration, Validation : design k8s cluster + install mastser and nodes + HA k8s cluster + provision infrastructure 10. Troubeleshooting : application failure + worker node failure + control plane failure + networking |

> 자격증에 대한 설명

- k8s 사용 많이 함

- 2시간, $300, 12개월 유효기관, 인터넷

- 객관식이 아님, 무작정 외우는 것 안됨

- documentation 보는법 알려줄거임

- Certified Kubernetes Administrator: https://www.cncf.io/certification/cka/

- Exam Curriculum (Topics): https://github.com/cncf/curriculum

- Candidate Handbook: https://www.cncf.io/certification/candidate-handbook

- Exam Tips: http://training.linuxfoundation.org/go//Important-Tips-CKA-CKAD

- k8s for beginner/admin/devloper 다른강의 소개

- 하지만 다른 내용도 추가할 계획임 예를들어 Auto scaling a cluster, Horizontal POD, autoscalers, Stateful Sets Kubernetes Federation, Admission Controllers

Core Conceptsssss

40 lectures • 2hr 57min

pdf download link

12. ETCD in Kubernetes 03:16

> 2가지 설치 방법이 있음

cluster의 정보들을 저장함. nodes, pods, configs, secrets, accounts 등

cluster 설정에 따라 다르게 배포됨

1. scratch

- wget etcd binary

-- advertise-client-url : 내부 IP 설정이 되어야함

2. kubeadm tool

- pod로 배포가능. -n kube-system etcd-master

- k exec etcd-master -n kube-system etcdctl get / --prefiex -keys-only

13. ETCD - Commands (Optional) 00:57

> cli툴도 있음

14. Kube-API Server 04:50

> kube-api가 핵심임. 각 객체들이 통신하는데 api를 사용함

kubectl을 생각하면 되는데, post 방식으로 요청을 보낼 수 도 있음

ETCD와 직접적으로 접촉함

pod 생성 순서

1. authenticate user

2. validate request

3. retrieve data -> api로 pod 생성 명령어 인식

4. update ETCD -> 상태 업데이트 (아직 node 할당 안됨)

5. scheduler -> node 할당 되어있지 않다는 것을 체크하고, api-server에 요청보내면 worker node의 kubelet에 요청

6. kubeletet -> container runtime engine에 image로 pod 만듦

+ update etcd -> 상태 업데이트

kubeapiserver.service의 설정

-etcd-cafile, etcd-certfile, etcd-keyfile

-kubelet-certificate-authority, kubeletpclient-certificate, kubelet-client-key, kubelet-https

-etcd-servers=https://127.0.0.1:2379

#kubeadmin

-n kube-system kube-apiserver-master

17. Kubelet 01:42

18. Kube Proxy 03:41

19. Recap - PODs 09:12

20. PODs with YAML 07:04

21. Demo - PODs with YAML 06:17

22. Practice Test Introduction Preview 05:51

23. Demo: Accessing Labs 02:55

24. Accessing the Labs 00:14

Link: https://uklabs.kodekloud.com/courses/labs-certified-kubernetes-administrator-with-practice-tests/

Apply the coupon code *****

25. Practice Test - Pods 00:01

26. Practice Test - Solution (Optional) 07:39

27. Recap - ReplicaSets 16:09

29. Practice Test - ReplicaSets - Solution (Optional) 07:45

30. Deployments 04:26

| apiVersion: v1 kind: ResourceQuota metada: name: compute-quota namespace: dev spec: hard: pods: "10" requests.cpu: "4" requests.memory: 5Gi limits.cpu: "10" limits.memory: 10Gi |

31. Certification Tip! 01:07

32. Practice Test - Deployments 00:03

33. Solution - Deployments (optional) 05:07

34. Namespaces 08:22

35. Practice Test - Namespaces 00:04

36. Solution - Namespaces (optional) 05:03

37. Services 13:50

38. Services Cluster IP 04:01

39. Services - Loadbalancer 03:42

40. Practice Test - Services 00:01

41. Solution - Services (optional) 05:00

> 모르는 거 없었음

42. Imperative vs Declarative 13:05

43. Certification Tips - Imperative Commands with Kubectl 02:03

44. Practice Test - Imperative Commands 00:05

46. Kubectl Apply Command 04:38

Here's some inspiration to keep going Preview00:00

'기타 > K8S' 카테고리의 다른 글

| udemy)CKA 강의 듣고 따라하기_3장_scheduling :: mightytedkim (0) | 2022.03.26 |

|---|---|

| udemy)CKA 강의 듣고 따라하기_2장_핵심개념 :: mightytedkim (0) | 2022.03.26 |

| Kubernetes) prometheus-statefulset 삭제 안됨 이슈_prom-operator (0) | 2022.03.16 |

| Kubernetes) Prometheus emptydir disk full_초기화 (0) | 2022.03.16 |

| Kubernetes)helm 설치 (0) | 2022.02.21 |